J’ai récemment obtenu la certification Nutanix Certified Master – Multi Cloud Infrastructure, l’occasion pour moi de revenir sur mon parcours de certification Nutanix.

Ma première sur le sujet remonte en 2018 avec la Nutanix Platform Professional, à l’époque, l’examen se passait déjà en ligne, avec la possibilité d’utiliser internet et la documentation, ce qui se rapproche plus de notre travail quotidien avec google à porté de main. Finalement ce modèle a été abandonné, il posait aussi de vrais soucis, car l’identité de celui qui passait l’examen n’était pas vérifiée.

Ce point n’est aujourd’hui plus du tout un problème même si vous passez les examens à distances, car Nutanix s’appuie sur la plateforme PSI et vous allez voir qu’ils ne prennent pas ça à la légère, j’ai même le sentiment que c’est de plus en plus strict.

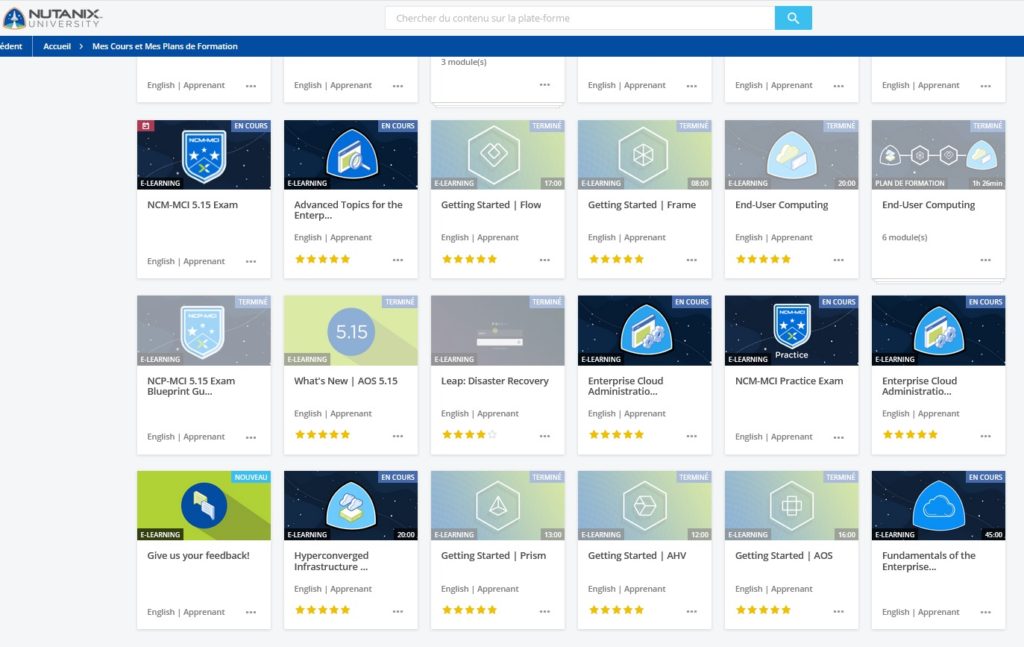

L’outil principal pour se former aujourd’hui est Nutanix University qui vient d’ailleurs de subir un petit lifting, le site est plus accessible et pratique à suivre, certaines sections sont traduites progressivement en français même si les examens se passent en anglais.

L’accès à la Nutanix University nécessite d’avoir un compte my.nutanix et la quasi-totalité du contenu est gratuit ! Il y a maintenant 4 niveaux d’expertises, dès 6 mois à 1 an d’expérience, jusqu’aux certifications les plus avancées. De nouveaux programmes ont fait leur apparition avec des parcours, orientés End User Computing, DevOps, Multicloud et Datacenter Services.

Lorsque vous aurez étudié tous les points d’un des plans de formations, essayez de parcourir l’ensemble des points des BluePrint de certifications: il s’agit de documents qui résument point par point ce qu’on attend de vous et ce que vous devez maîtriser pour la certification. C’est un outil indispensable, qui permet de savoir exactement ce qu’on attend de vous, ce que vous devrez réviser.

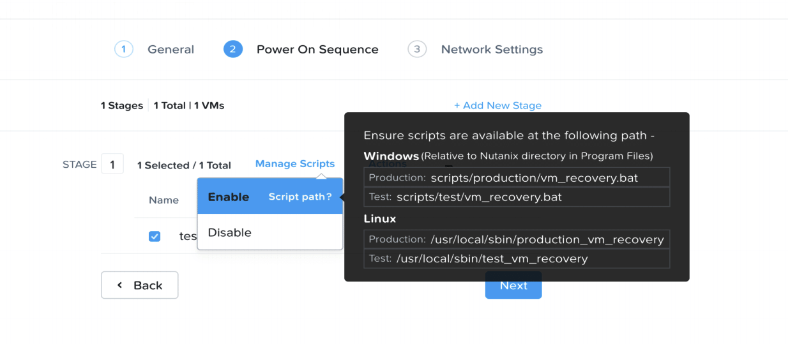

Ensuite, il est temps de s’inscrire et planifier votre certification (attention les horaires sont au format Anglais, si vous arrivez 30 minutes en retard, votre certif est fichue) . Pour passer l’examen à distance, vous devrez installer leur outil qui permet de surveiller votre machine afin d’éviter toute forme de tricherie ou d’enregistrement de la session.

N’hésitez pas à arriver 30 minutes avant le début de votre examen comme recommandé, car la procédure de sécurité peu être assez longue :

- vérification de votre pièce d’identité.

- Vérification de la salle, avec votre webcam, vous allez devoir montrer, les 4 murs, un bureau vide, avec un seul moniteur, pas d’enceintes.

Concernant les conditions, si quelqu’un rentre dans la pièce, l’examen est un échec, pensez à vous enfermer. Vous ne devez pas avoir de stylo, ni de téléphone, ni de smartwatch, ni d’écouteurs. Il est interdit de manger même un chewing-gum ou un bonbon, boire, parler, de chuchoter, il ne faut pas se masquer la bouche, j’ai par exemple l’habitude de me coiffer la barbe pendant que je réfléchis, et le surveillant m’a déjà mis l’examen en pause pour me demander d’arrêter de masquer ma bouche.

Avec plus d’une dizaine de certifications, j’ai exploré les différentes branches que ce soit celles orientées administration, architecture, mais aussi avant-vente ou service. Ayant participé à de nombreuses bêtas et c’est devenu pour moi un moyen de régulièrement mettre à jour mes connaissances, car les innovations apparaissent très régulièrement. Comme beaucoup d’éditeurs, l’obtention d’une certification débloque le badge associé sur Acclaim, ce service permet entre autres, la vérification d’authenticité et de la date d’obtention de la certification, voici ma page pour se faire une idée : https://www.youracclaim.com/users/matthieu-gioia/badges

Je ne peux qu’encourager les plus curieux d’entre vous à essayer le nouveau parcours Nutanix Certicied Associate, qui est le programme pour commencer à bâtir une carrière dans la technologie multicloud.