Je l’ai déjà indiqué dans un précédent article, je ne suis pas un spécialiste du matériel Dell et le client n’en dispose que pour nos clusters Nutanix.

Voici le script que j’utilise pour configurer les noeuds en mode “Maximum Performance”.

Si vous débutez comme moi sur le sujet, je vous conseille mon précédent article qui décrit en détail l’installation de l’outil de configuration distant RACADM (Remote Access Controller Admin).

#Chargement Cmdlet Nutanix

asnp nutanix*

#Choix du cluster

$Cluster = Read-host "IP address of the Nutanix cluster to update"

$iDracPwd = Read-host "iDrac root Password"

Connect-NTNXCluster $Cluster -AcceptInvalidSSLCerts -UserName:Admin -ForcedConnection

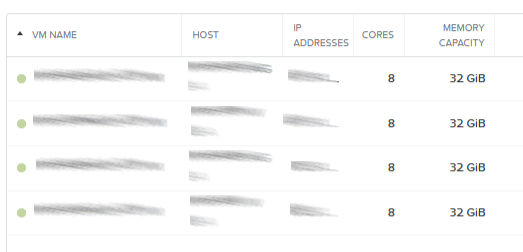

Get-NTNXHost | select name,ipmiaddress,managementservername

$IPMIs = (Get-NTNXHost).ipmiaddress

foreach ($IPMI in $IPMIS) {

write-host "Modification des parametres BIOS du noeud $IPMI"

racadm.exe -r "$IPMI" -u root -p $iDracPwd set bios.SysProfileSettings.SysProfile Custom

racadm.exe -r "$IPMI" -u root -p $iDracPwd set bios.SysProfileSettings.ProcPwrPerf MaxPerf

racadm.exe -r "$IPMI" -u root -p $iDracPwd jobqueue create BIOS.setup.1-1

Cette commande permet d'avoir un retour sur la configuration du parametre

#racadm.exe -r "$IPMI" -u root -p $iDracPwd get bios.SysProfileSettings.ProcPwrPerf

}

exit

Ce script ne contient pas la phase de redémarrage nécessaire à la prise en compte des paramètres, comme il s’agit de clusters Nutanix.