Les nouveaux nœuds Nutanix ont été réceptionnés. Ils sont maintenant rackés, câblés en datacenter, prêts à être ajoutés aux clusters existants.

Afin de réaliser l’opération d’installation, le réseau est configuré en “access” sur le même VLAN que mes autres CVM. Je modifierai la configuration après l’ajout du noeud.

Autre prérequis l’iDrac (oui, ce sont des serveurs Dell) est sur le même plan d’adressage que les autres IPMI, déjà en place dans le cluster.

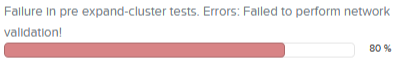

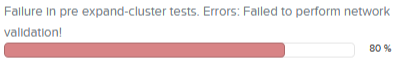

J’ai déjà eu le problème avec un iDrac sur un autre VLAN et on obtient une erreur : “Failed to perform network validation !”

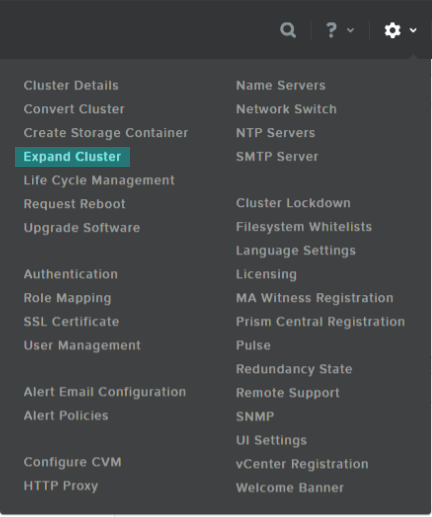

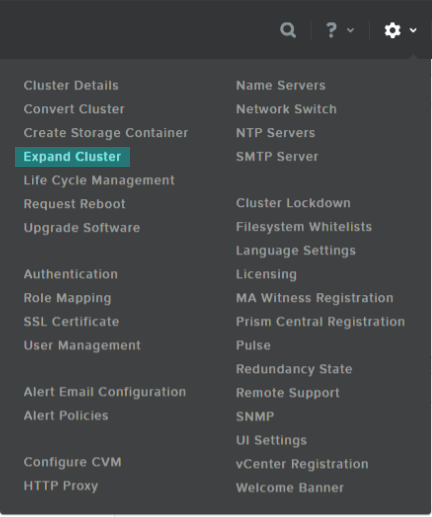

Je prépare mes adresses IP et je suis enfin prêt pour l’Expand Cluster.

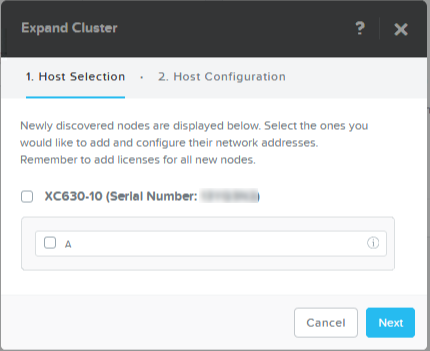

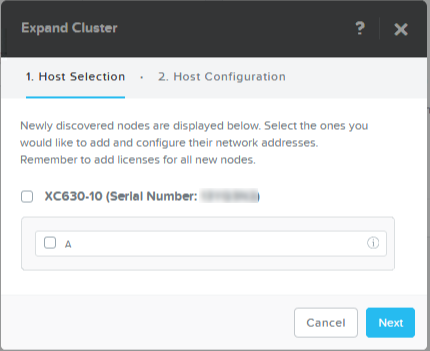

Comme le réseau est correctement configuré, le nouveau nœud est disponible.

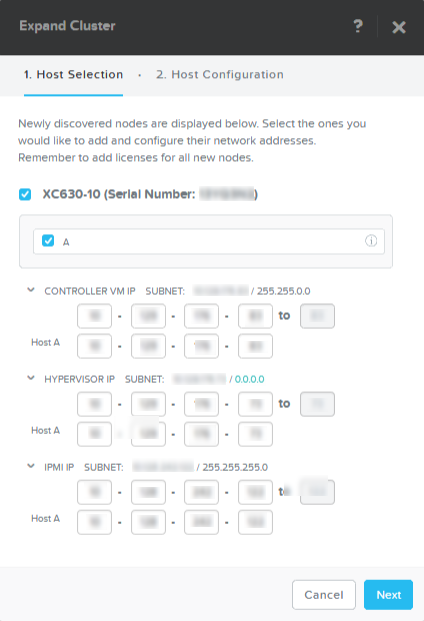

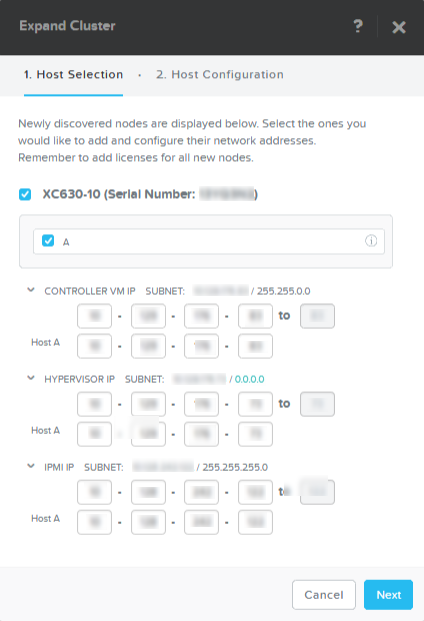

Je renseigne les champs pour les adresses IP qui permettent aisément la configuration de plusieurs nœuds à la fois, si les adresses se suivent.

Concernant la détection automatique des masques de sous-réseau, je pense qu’il y a un souci comme vous pouvez le voir sur la capture. Ils ne sont jamais corrects, mais l’installation se poursuit sans encombre.

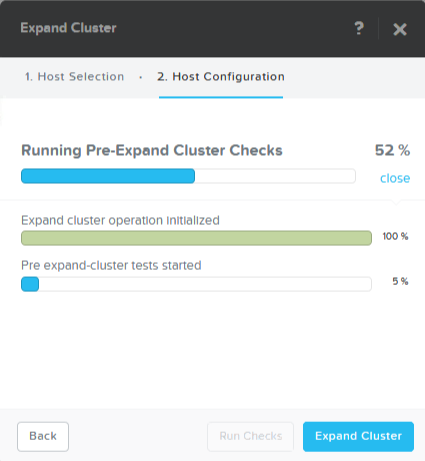

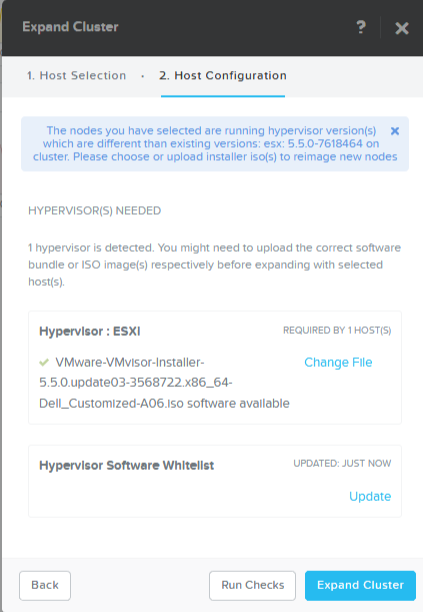

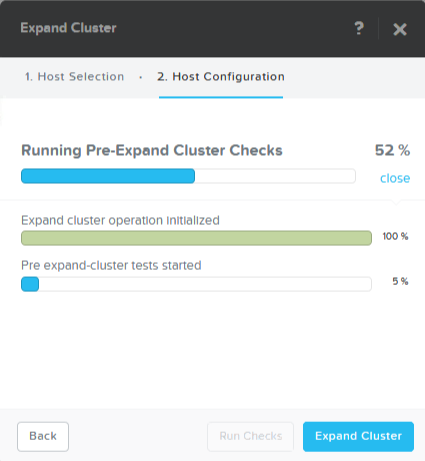

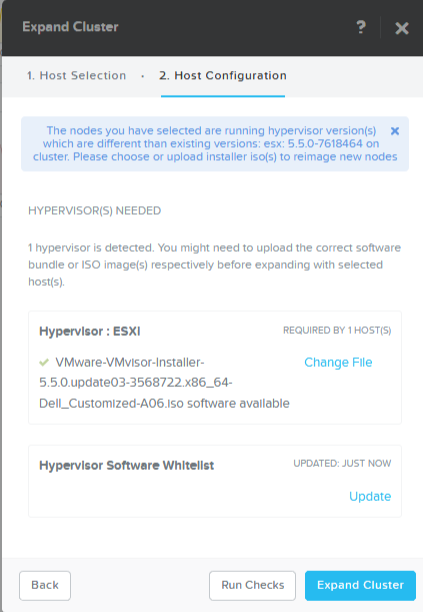

La deuxième étape consiste à ré-imager l’hôte avec le même hyperviseur que les autres membres du cluster, dans mon cas ESXi.

Ici, on constate que la version n’est pas tout à fait la même. Je procéderai avec VMware Update Manager pour l’application des derniers correctifs et venir au même niveau que le cluster. Je procède à la phase de vérification en cliquant sur “Run Checks”.

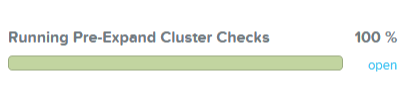

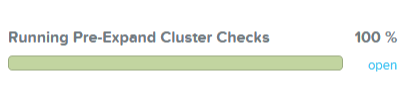

SI la vérification est concluante…

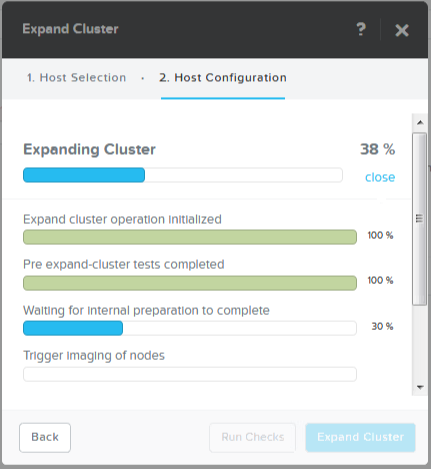

…il est temps de cliquer sur “Expend Cluster”.

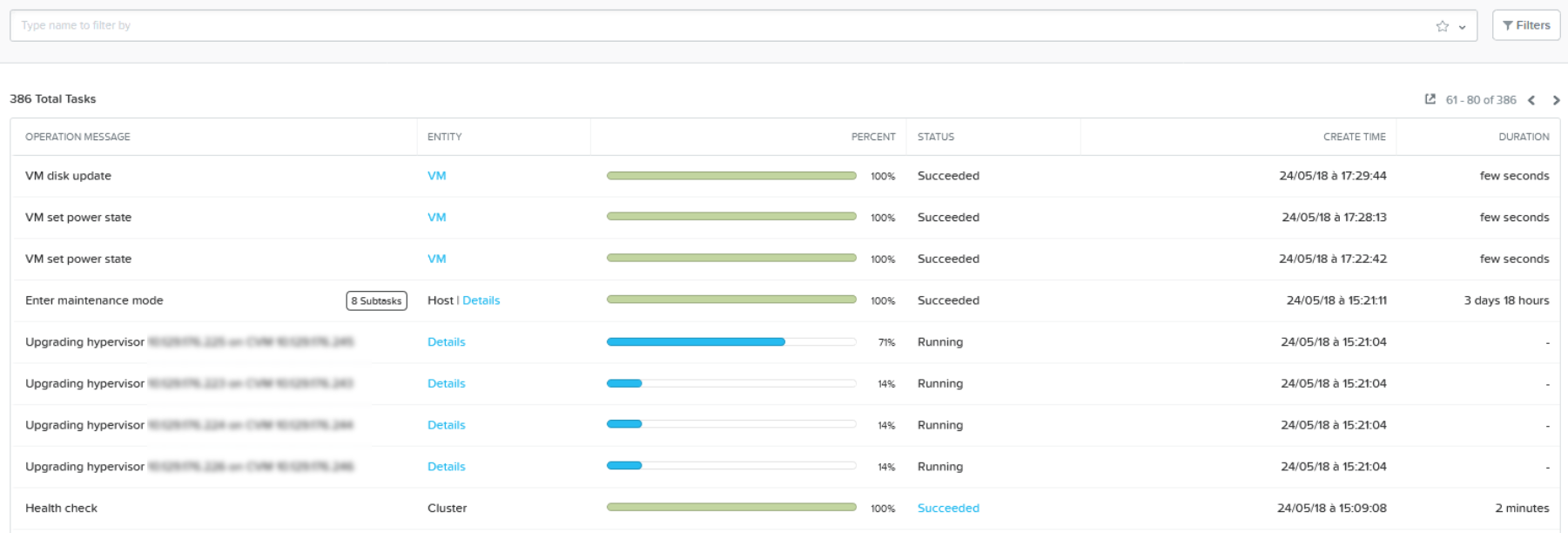

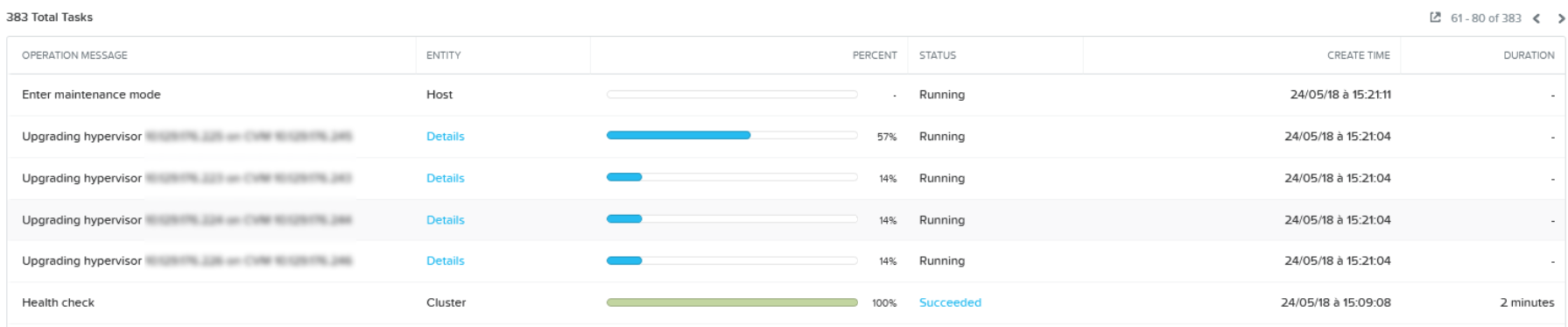

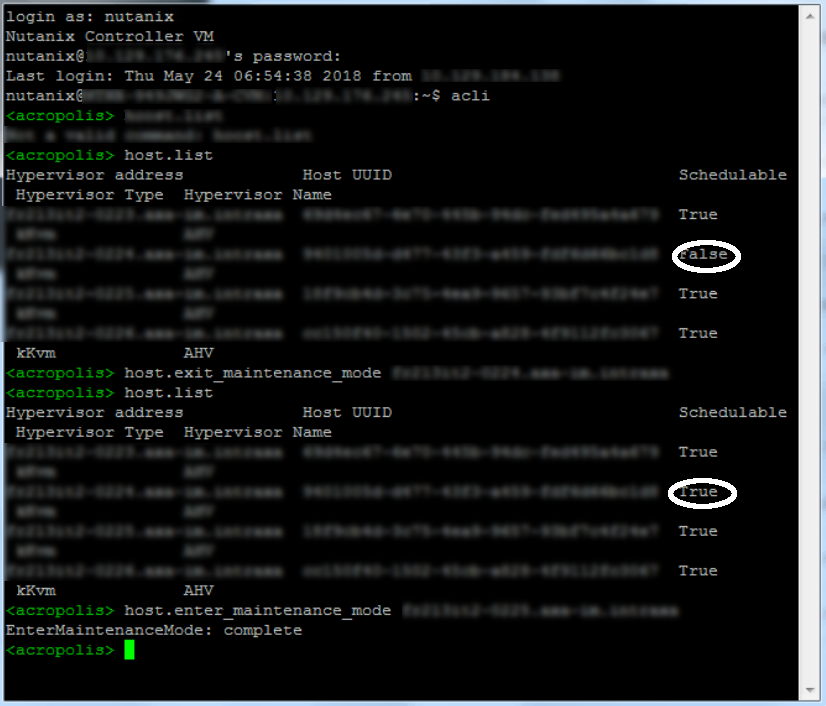

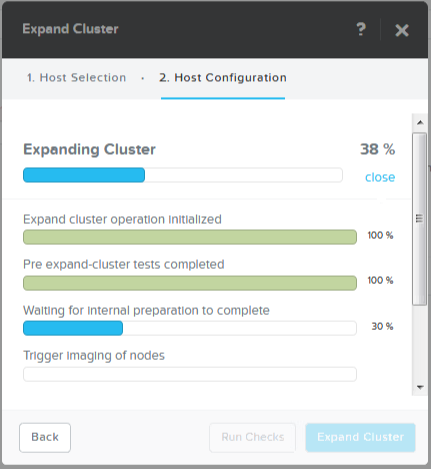

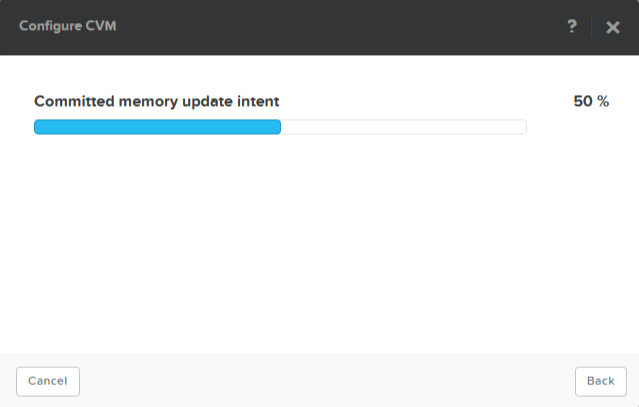

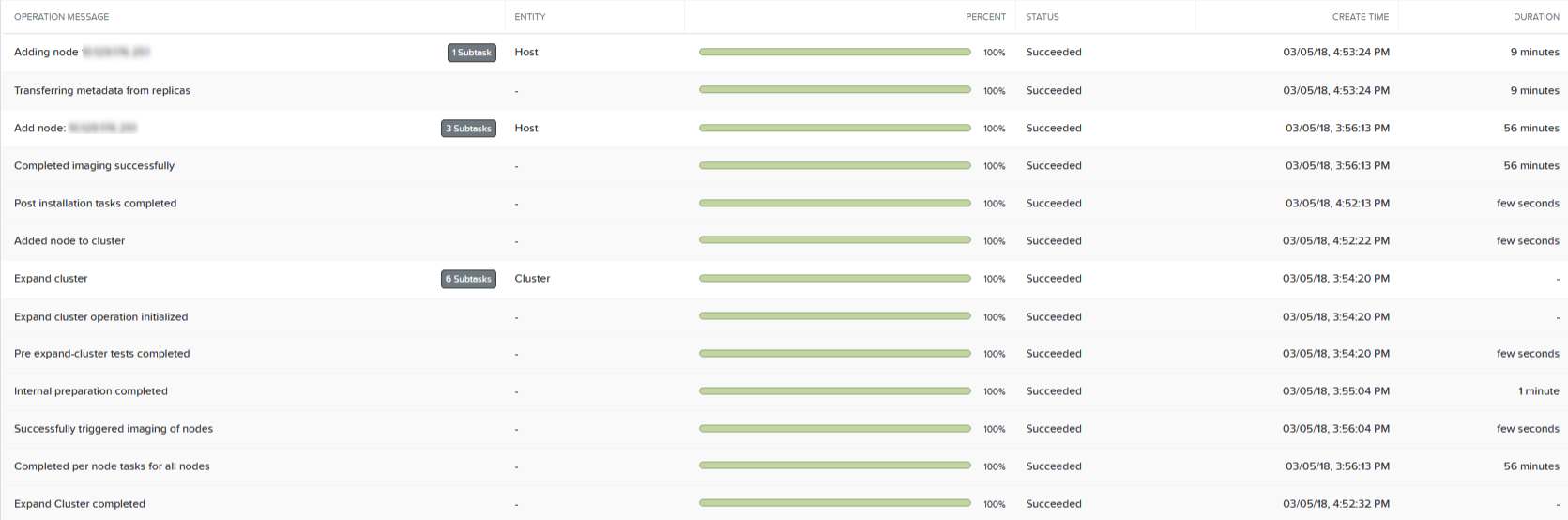

L’opération est assez longue, elle contient une multitude de sous-tâches.

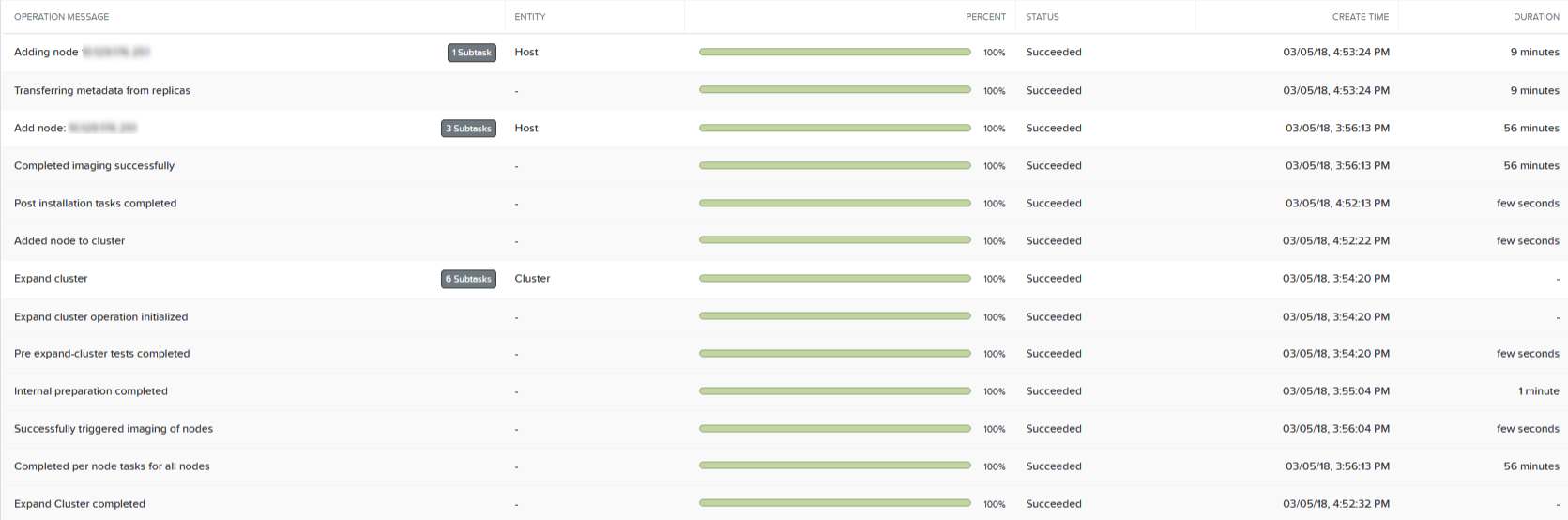

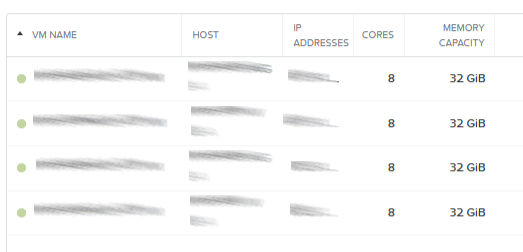

L’ajout du nœud a pris une heure et s’est terminé correctement. Il me reste maintenant à configurer l’hyperviseur et le cluster profitera rapidement d’une ressource supplémentaire pour repartir la charge.

Encore une fonctionnalité de Prism très pratique. L’important est de bien respecter les prérequis et l’extension du cluster sera réalisée en quelques clics seulement.

Partager la publication "OneClick : Expand Cluster ajout d’un nouveau noeud Nutanix"