J’ai découvert les produits Vembu au VMworld 2017 à Barcelone et j’ai commencé à les tester à mon retour de l’événement.

Finalement, le test s’est tellement bien passé que les sauvegardes sont en place depuis cette période et les quelques restaurations, dont j’ai eu besoin, ont parfaitement fonctionné. Petit retour sur l’installation et la configuration de l’un des produits de cet éditeur encore trop méconnu.

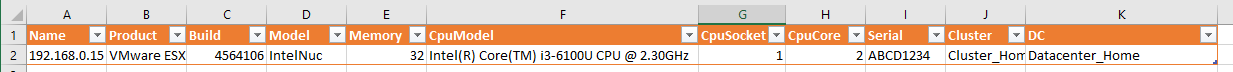

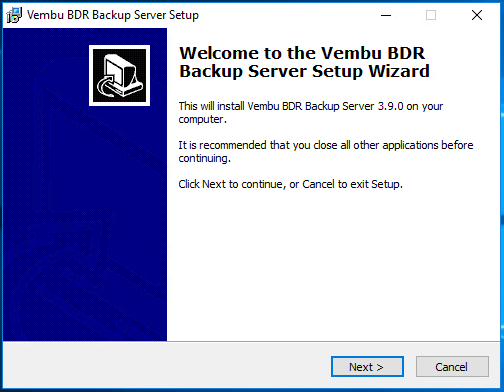

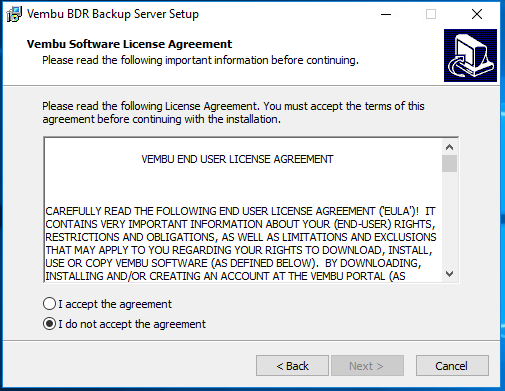

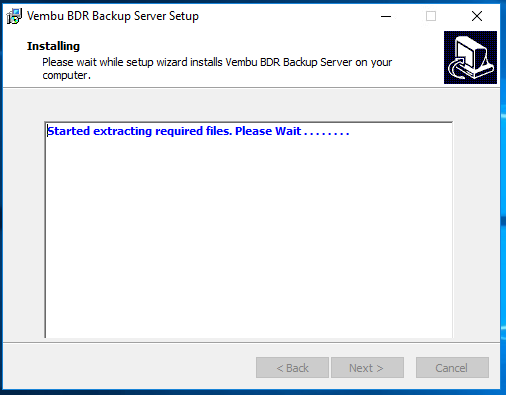

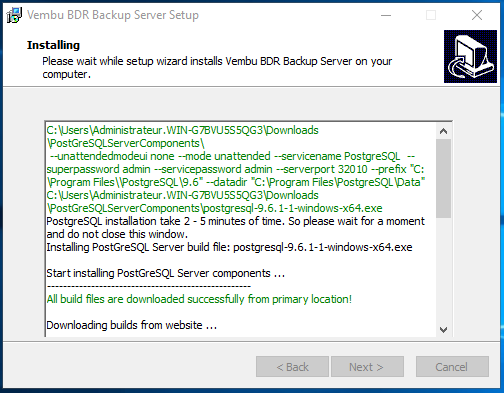

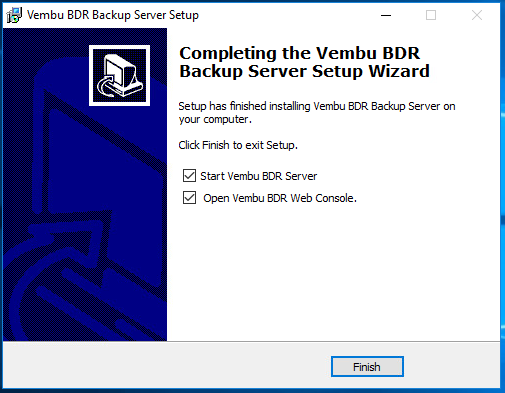

Voici le déroulement du setup. Celui-ci est très simple les sources sont disponibles directement sur le site de vembu :

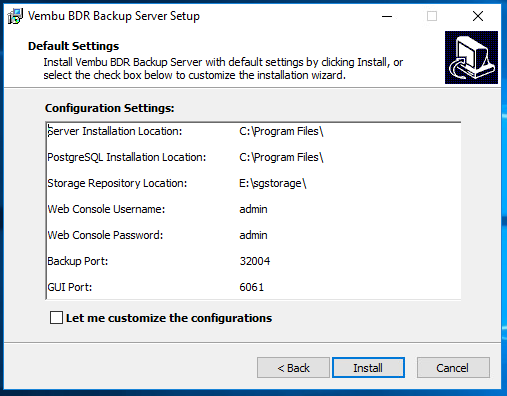

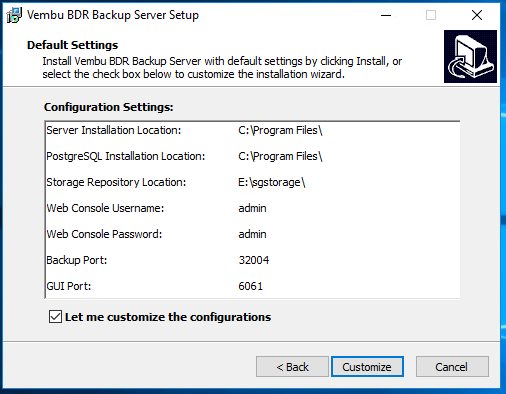

Le setup par défaut est le suivant, mais l’installation est entièrement personnalisable :

Install ou Customize

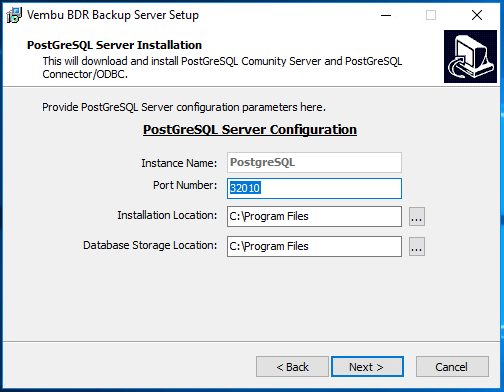

Choix du nom de l’instance de la base, port réseau, emplacement des sources du serveur PostgreSQL ainsi que de la base de données :

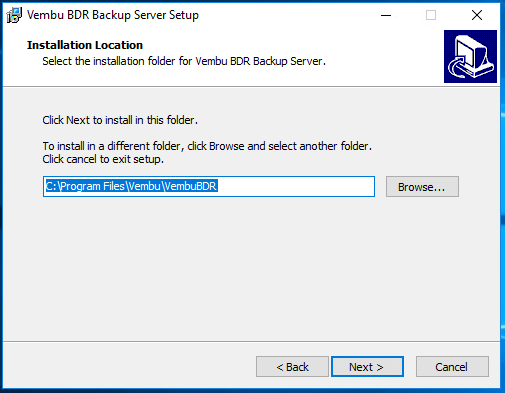

Choix de l’emplacement du produit en lui-même :

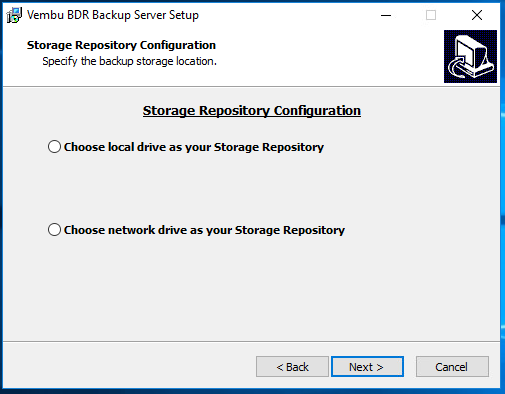

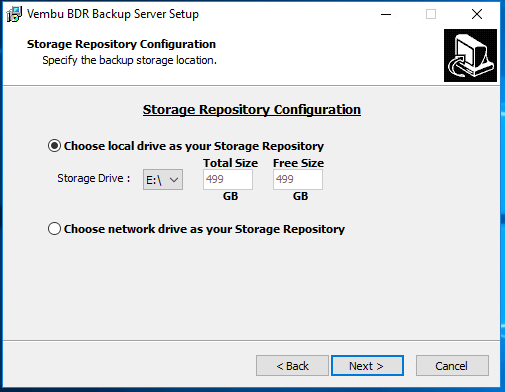

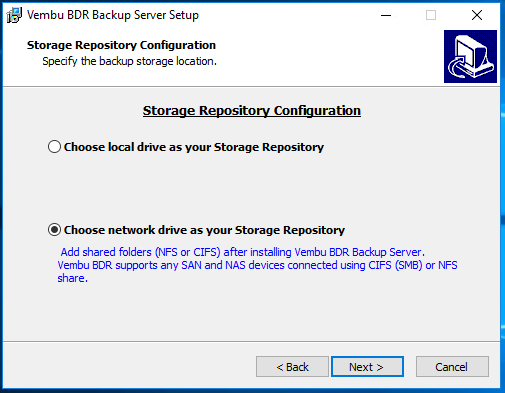

Choix des emplacements de stockage des sauvegardes qui peuvent être locales au serveur de sauvegarde ou sur un partage réseau NFS ou CIFS. Cette option est complétement paramétrable par la suite :

Pour ma part, j’ai ajouté un disque de 500GB à la VM :

Mais vous pouvez utiliser du NFS ou CIFS :

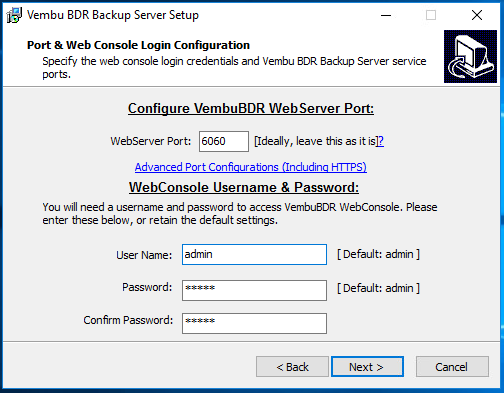

Choix du port de communication à l’interface Web qui permettra l’administration de la solution ainsi que du compte et du mot de passe pour s’y connecter :

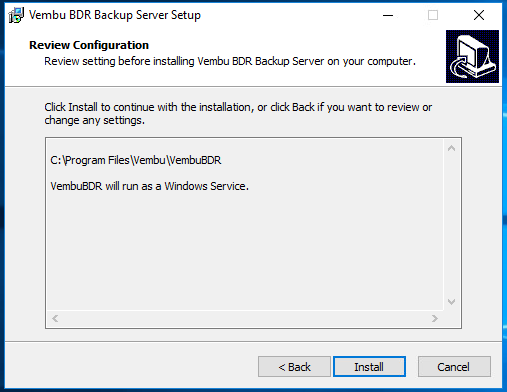

Enfin, le récapitulatif du chemin d’installation et le setup indique que l’application sera déclarée en service Windows :

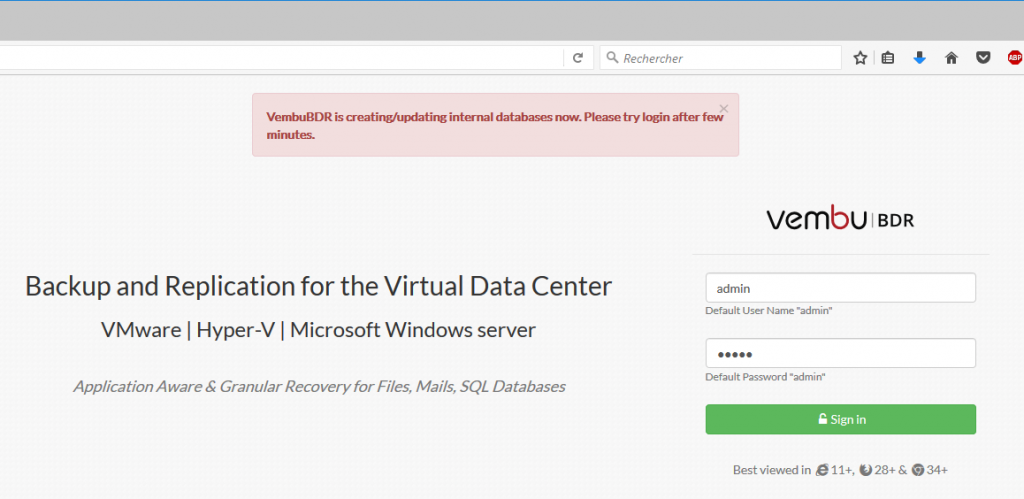

Une fois le setup effectué, attendre quelques minutes pour l’initialisation de la base de données afin de se connecter à l’interface d’administration. Sinon vous aurez ce message d’erreur :

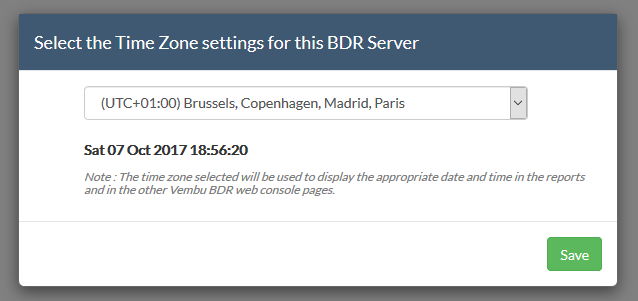

Après la connexion, configurez la timezone :

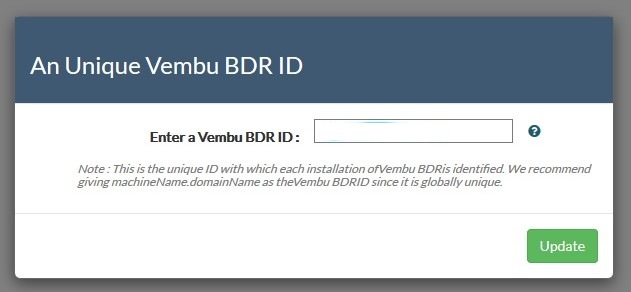

Définir un ID unique Vembu BDR. Comme recommandé, je suis parti sur le FQDN du serveur :

Vous arrivez ensuite sur cette page :

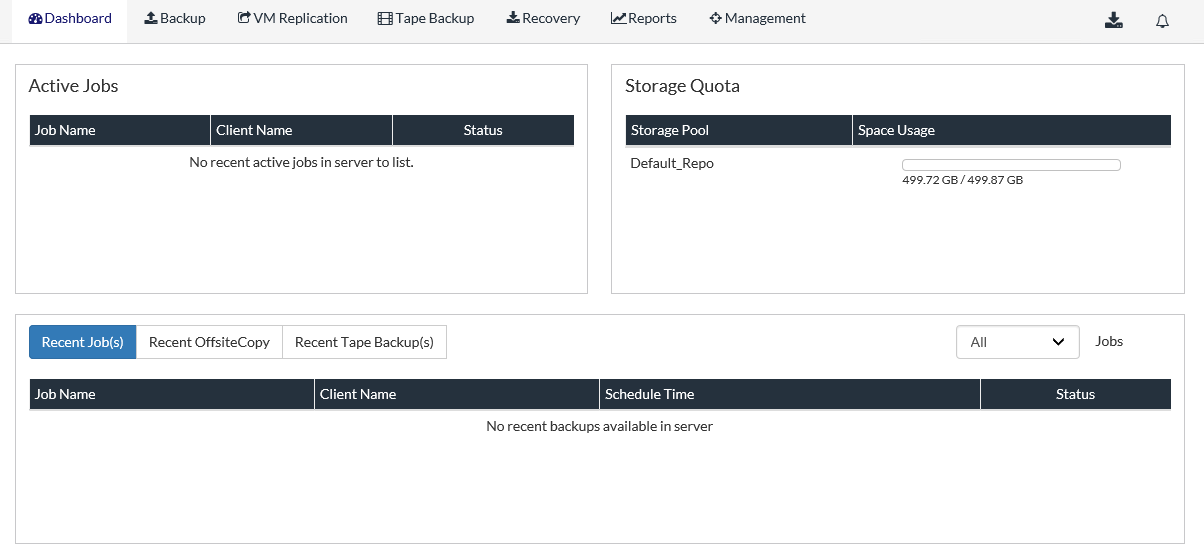

Le dashboard est vide pour le moment, il n’y a que l’état des emplacements de stockage des sauvegardes :

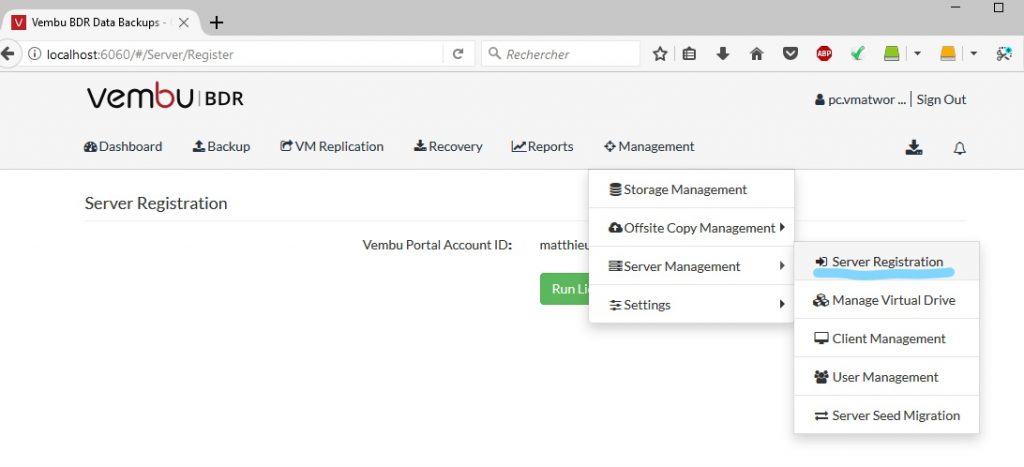

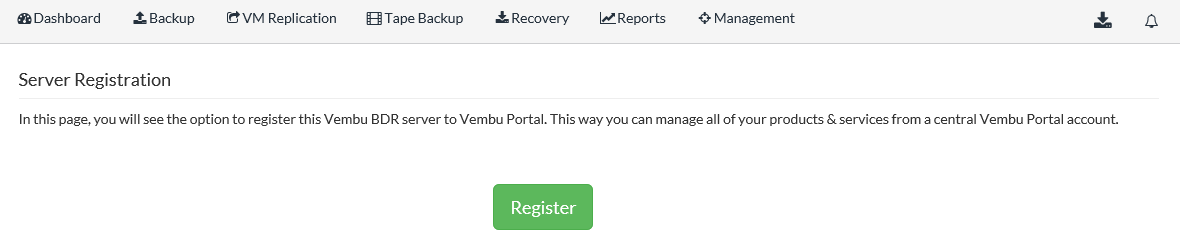

Il faut procéder à l’enregistrement du serveur de sauvegarde, si ce n’est pas déjà le cas, créer un compte sur https://portal.vembu.com

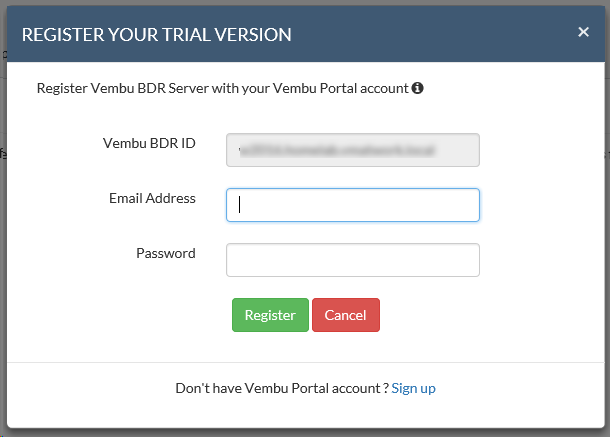

C’est le moment de renseigner le compte vembu :

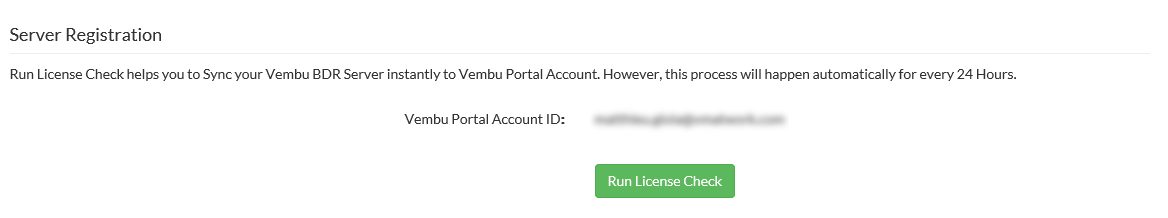

Tout se déroule correctement le serveur est enregistré:

Il faut maintenant configurer la sauvegarde, ici le choix est plutôt large, pour VMware cela peut être un/des vCenters ou directement les hôtes ESXi, pour Microsoft les hôtes Hyper-V ou partage SMB et enfin directement des machines Windows :

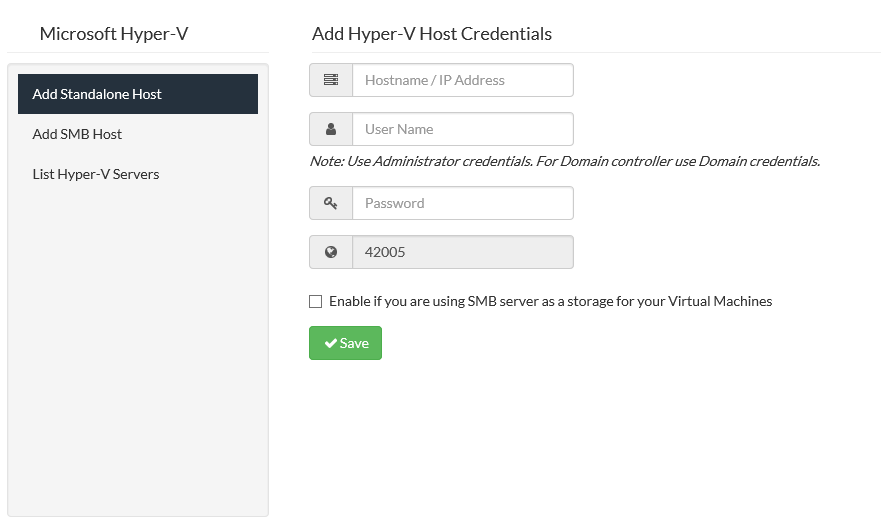

Microsoft Hyper-V Standalone:

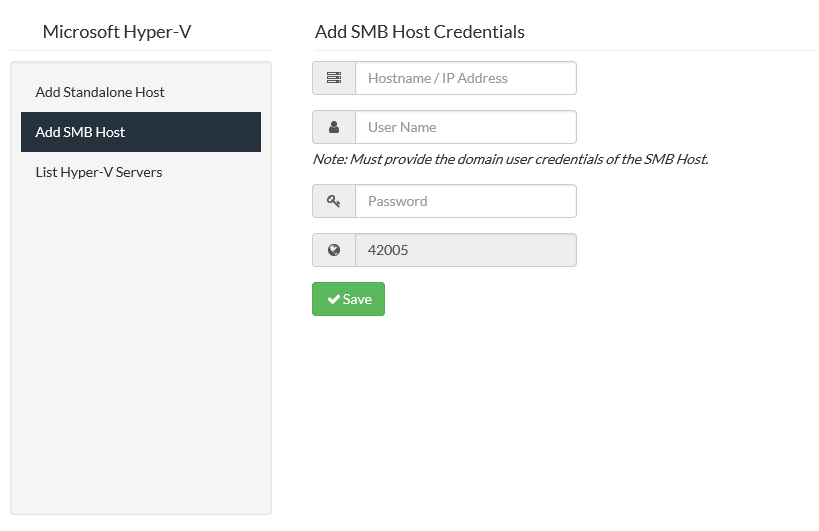

Microsoft Hyper-V SMB Host :

Machine Windows Serveur ou Workstation :

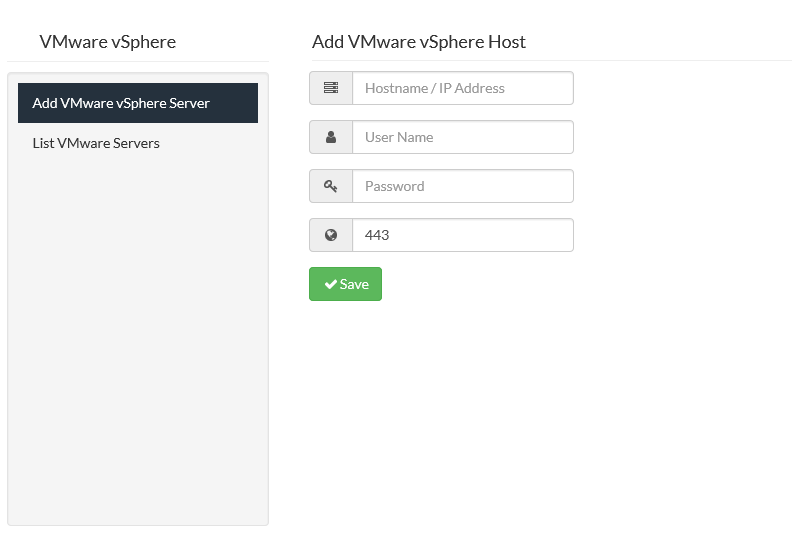

Pour VMware, Host ou vCenter :

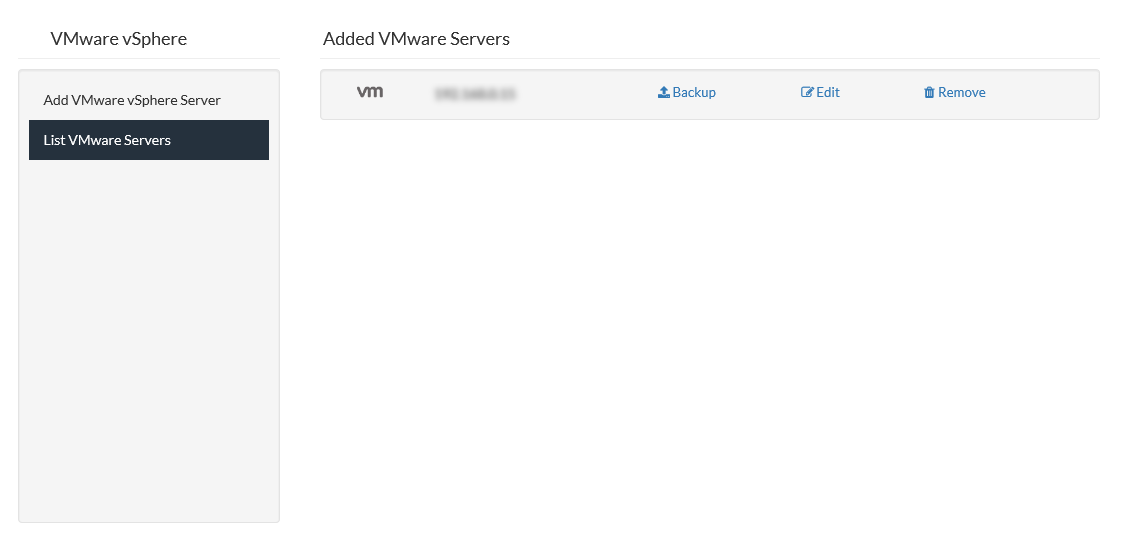

Une fois les serveurs ajoutés, ils sont visibles dans la liste des serveurs. C’est ici que je vais sélectionner la liste des machines à sauvegarder (en cliquant sur Backup), éditer le mot de passe ou simplement supprimer la connexion :

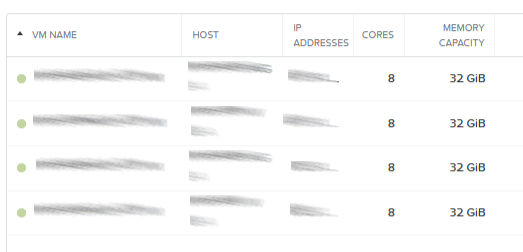

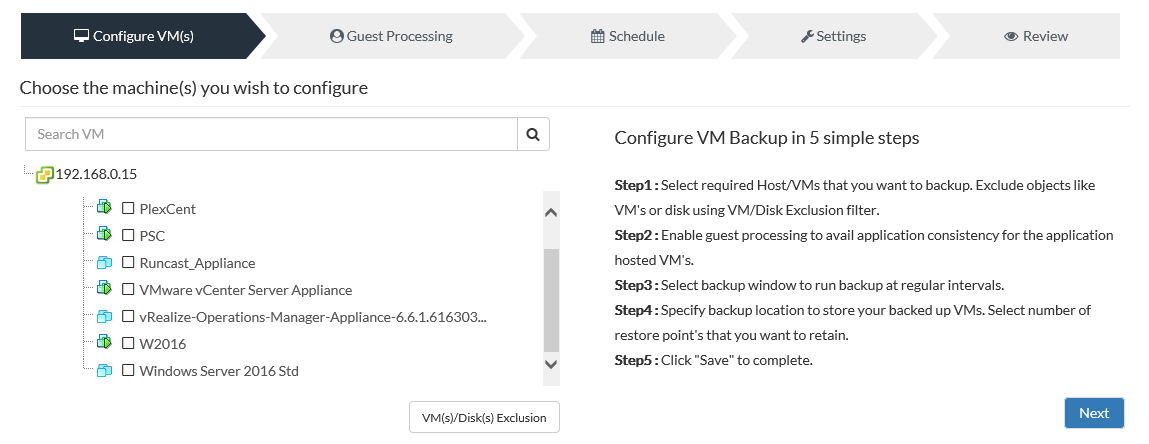

Sélection des VMs, ici le choix est très granulaire et les exclusions des VMs ou de disques bien pensées:

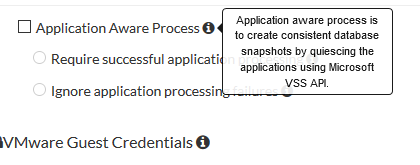

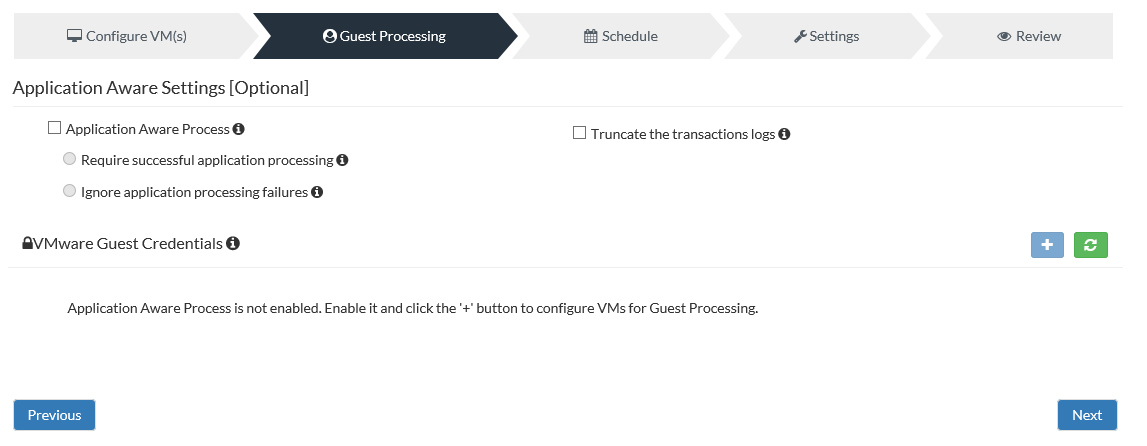

Choix des options de sauvegardes. Ici, plusieurs possibilités concernant les VSS Windows, les logs et processus en cours :

Voici le détail de chaque option, c’est aussi bien que chez les ténors du marché :

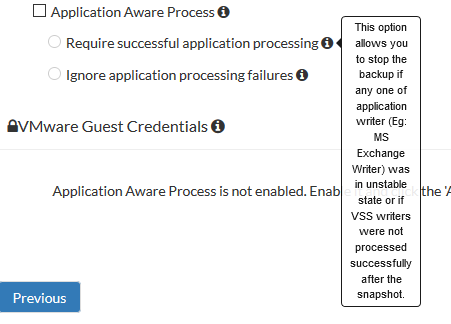

Application Aware Process:

Require successful application processing :

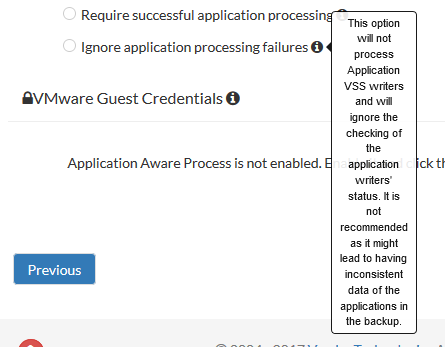

Ignore application processing failures :

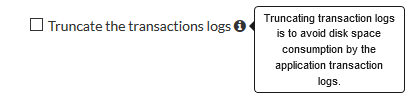

Truncate the translactions logs :

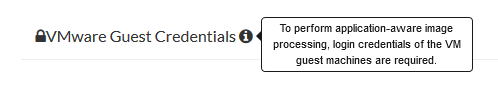

VMware Guest Credentials :

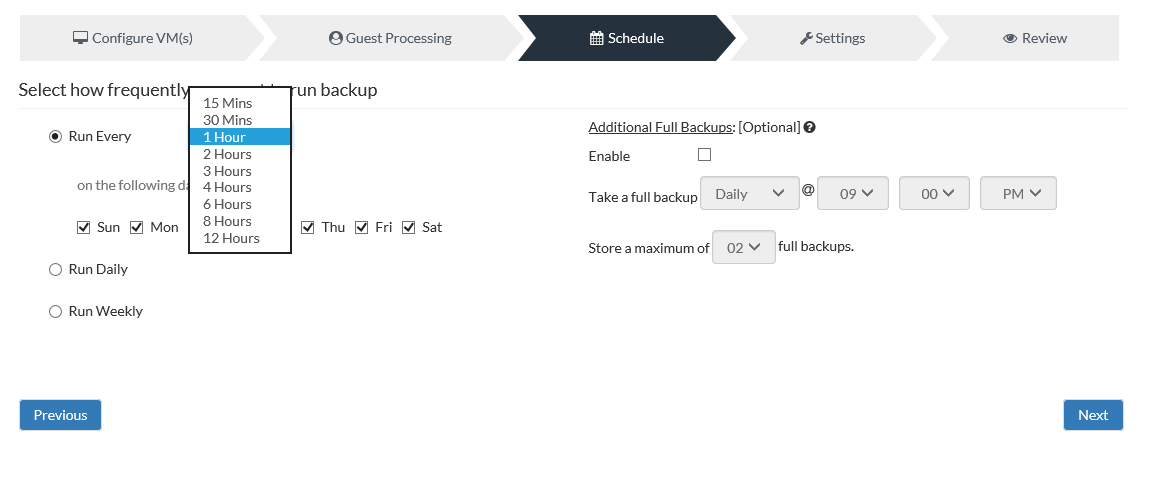

Je passe à la planification. Ici, la sauvegarde incrémentielle peut être effectuée de 15min à 12 heures. Sur le même onglet, on pourra planifier optionnellement des sauvegardes complètes :

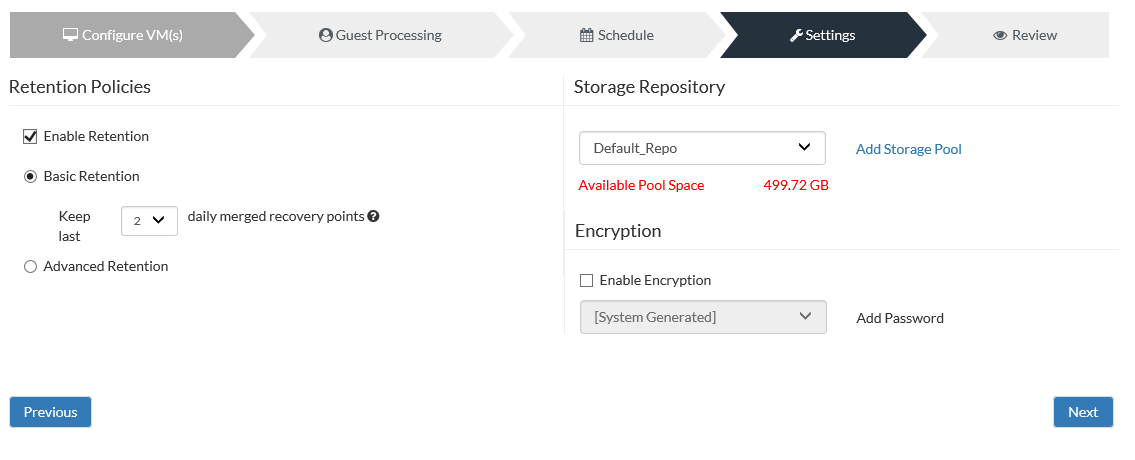

Stratégie de rétention, choix de la destination de stockage de la sauvegarde ainsi qu’activation du chiffrement :

Stratégie de rétention, choix de la destination de stockage de la sauvegarde ainsi qu’activation du chiffrement :

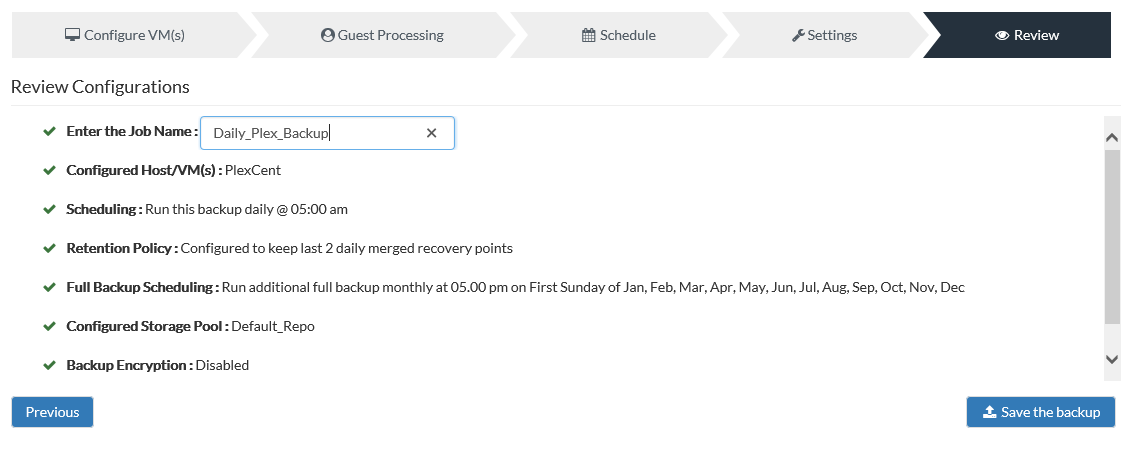

Résumé de la tâche, je touche au but :

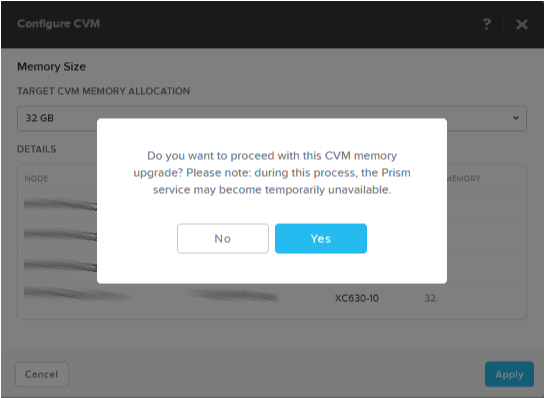

Dernière confirmation lorsqu’on clique sur Save the backup :

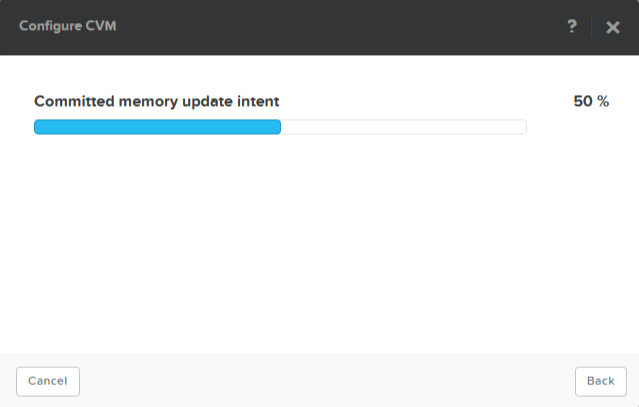

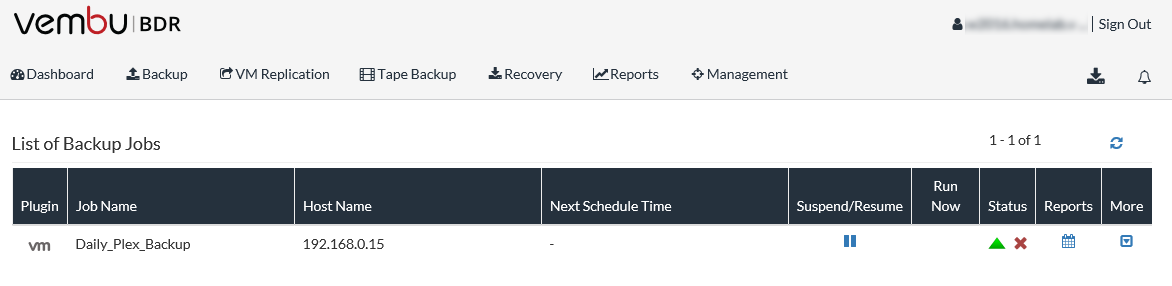

La sauvegarde est en place !

J’ai réalisé ce billet seulement maintenant car je voulais être certain d’avoir éprouvé la solution.

Lorsqu’il s’agit de sauvegarde, c’est en général notre dernière chance donc pas question de partir sur un produit qui ne ferait pas correctement le boulot.

D’ailleurs, celui-ci dépasse largement mes attentes et je pense qu’il peut répondre au besoin de nombreuses entreprises. Il suffit d’aller jeter un œil sur leur catalogue pour comprendre qu’ils proposent une très large gamme de produits qui sera s’adapter à beaucoup de besoins.

L’éditeur m’a récemment contacté pour m’indiquer qu’il proposait à l’occasion des “World Backup Day”.

Une promotion de 10% sur ces produits aux travers de ce lien : https://www.vembu.com/world-backup-day-2018/