L’upgrade des clusters Nutanix s’annonçait pourtant très bien et c’était avec confiance que j’attendais la fin du passage de Life Cycle Management (LCM) sur les différents nœuds.

Malheureusement au 18e nœud, le serveur redémarre en boucle et le diagnostic tombe : le satadom est mort…

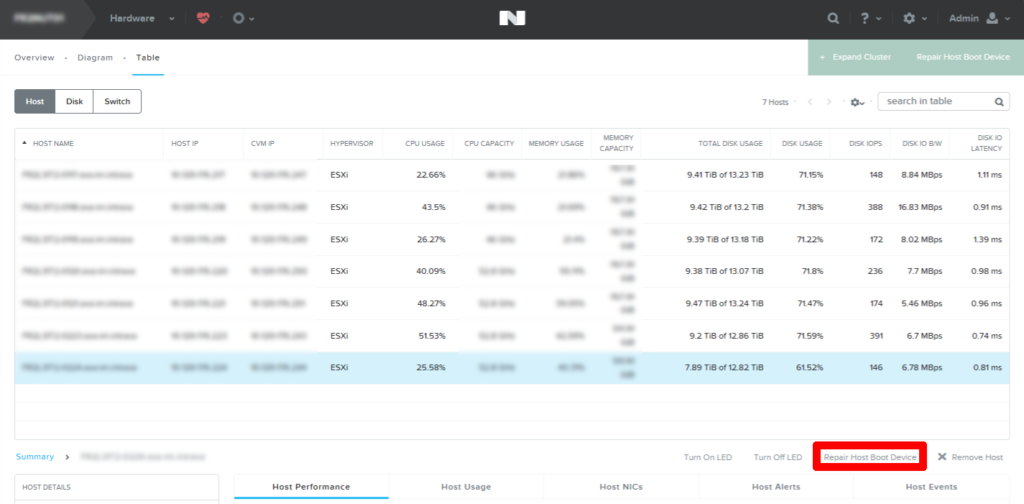

Après l’intervention du technicien en datacenter et remplacement de la pièce, il existe une option directement accessible depuis Prism dans la vue Hardware > Table > Host > Repair Host Boot Device afin de régler rapidement ce problème.

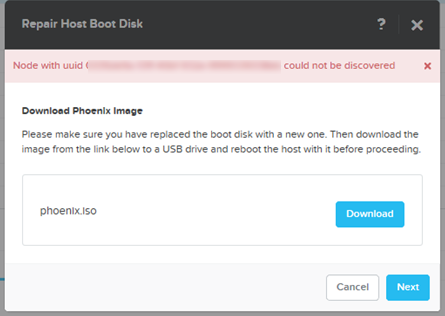

Mais comme dans la plupart des réseaux d’entreprise avec du vlan tagging, l’absence de gestion du réseau sans ESXi ne va pas nous aider à réparer notre composant.

À moins d’avoir accès au switch et de pouvoir modifier la configuration du port pour le passer en “access” sur le bon numéro de vlan. Mais dans ce cas, vous n’auriez pas le message “Node with uuid furferferfu could not be discovered” :

Profitez d’être sur cet écran pour télécharger l’iso Phoenix , il servira plus tard.

Allez récupérer l’iso correspondant à votre build pour ESXi. Pour ma part, 6.5 U1 de chez Dell.

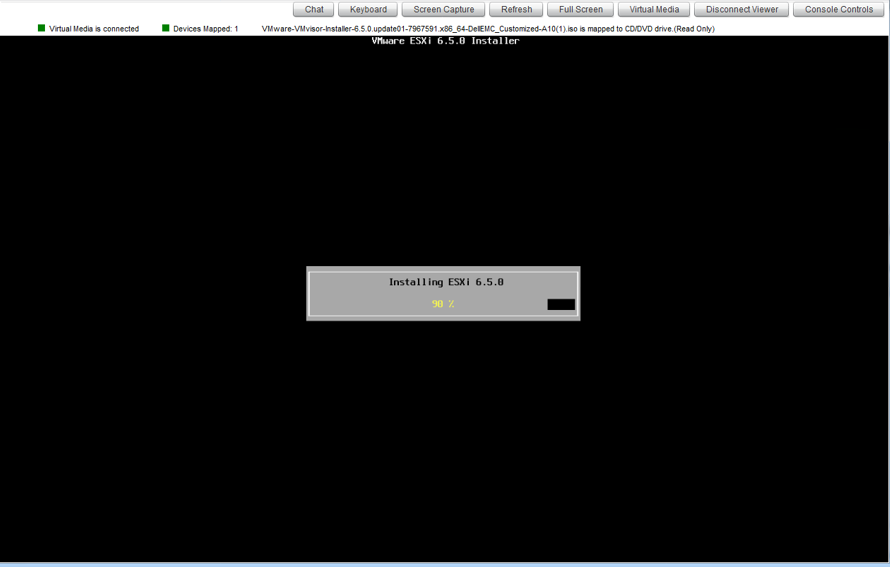

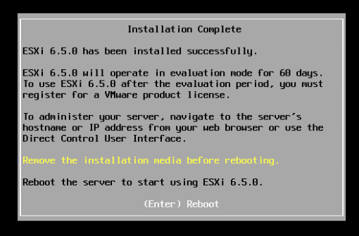

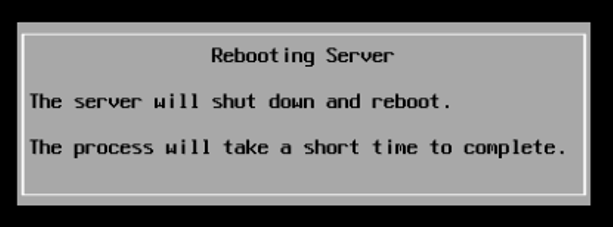

Il faut maintenant monter l’iso de l’ESXi et l’installer sur le satadom fraîchement remplacé.

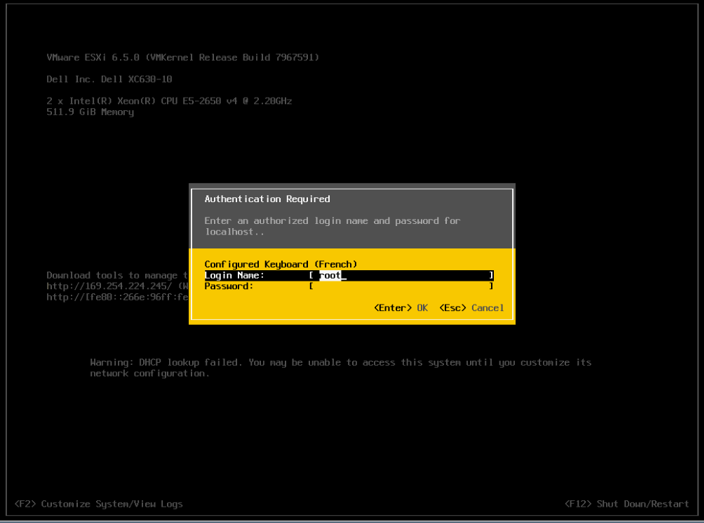

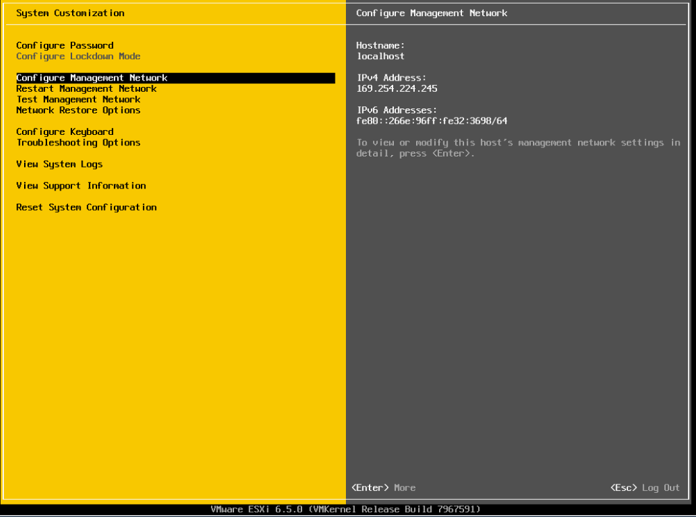

Après le reboot, il faut maintenant reconfigurer l’IP de management de cet ESXi. Je passe par la DCUI pour réaliser l’opération rapidement. On appuie sur F2, puis on entre le mot de passe root. /!\attention aux mapping de touches hasardeux en cas de changement azerty-qwerty et console iDrac.

Ensuite, il suffit de choisir “configure Management Network”.

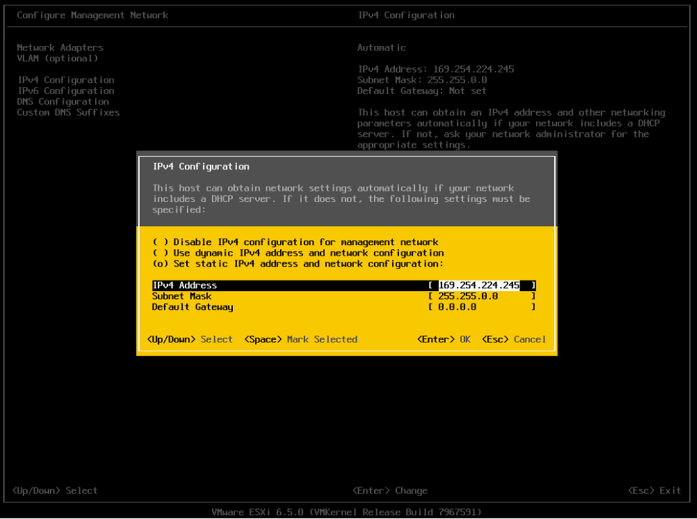

Et je configure l’IP comme il faut :

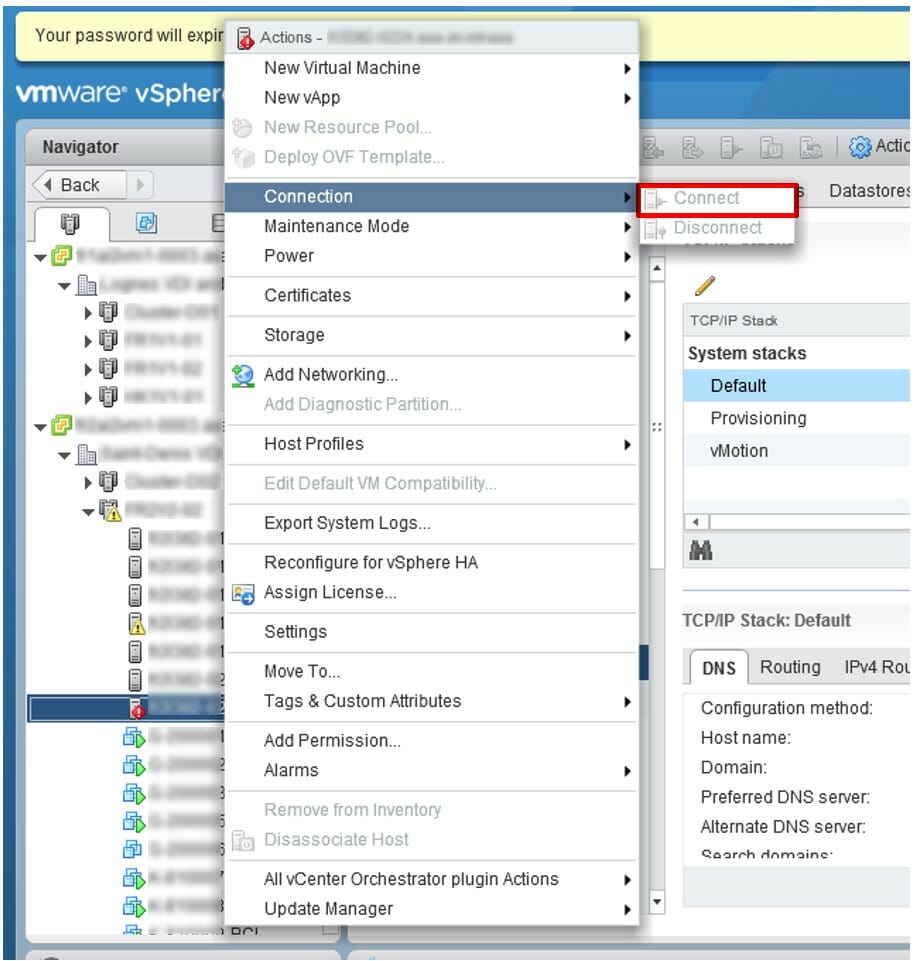

Il est temps de réintégrer l’hôte ESXi au vCenter, mais vous pouvez aussi réaliser la suite directement sur l’ESXi. Clic droit sur l’hôte > Connection > Connect

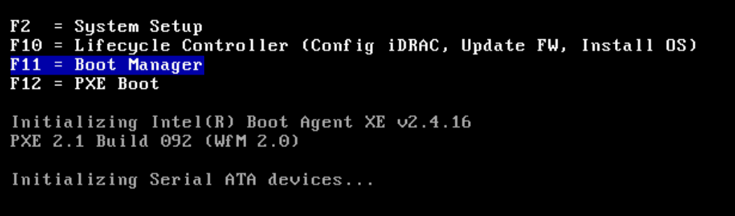

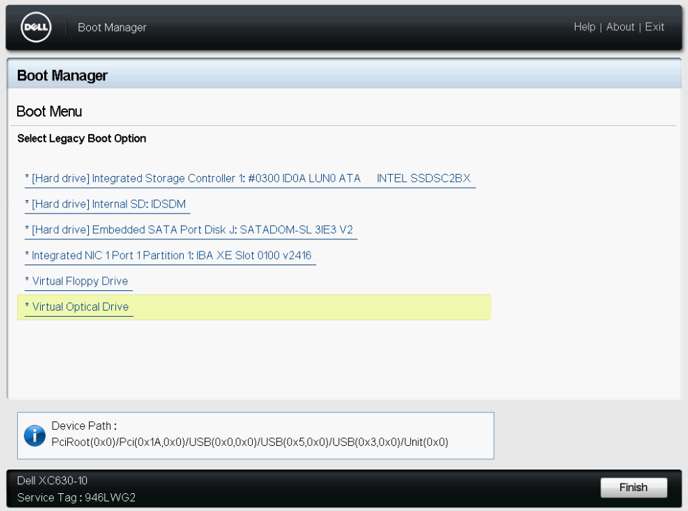

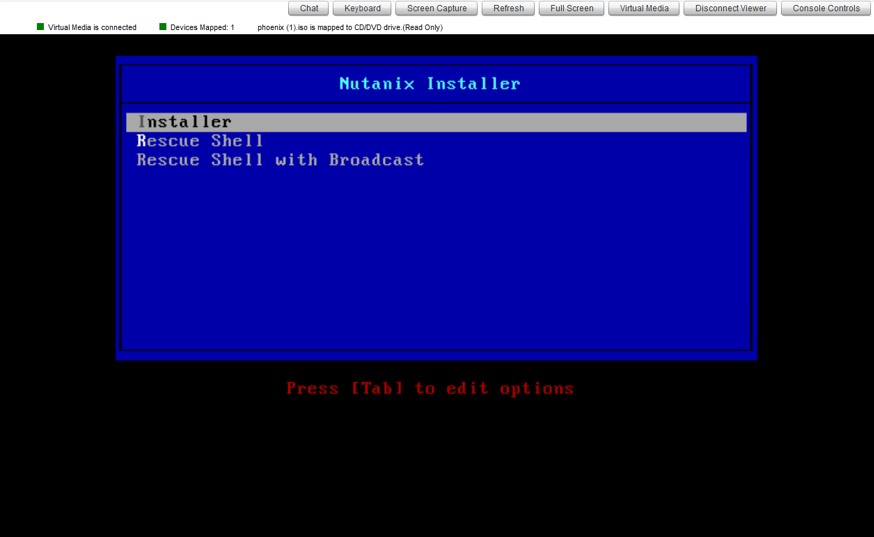

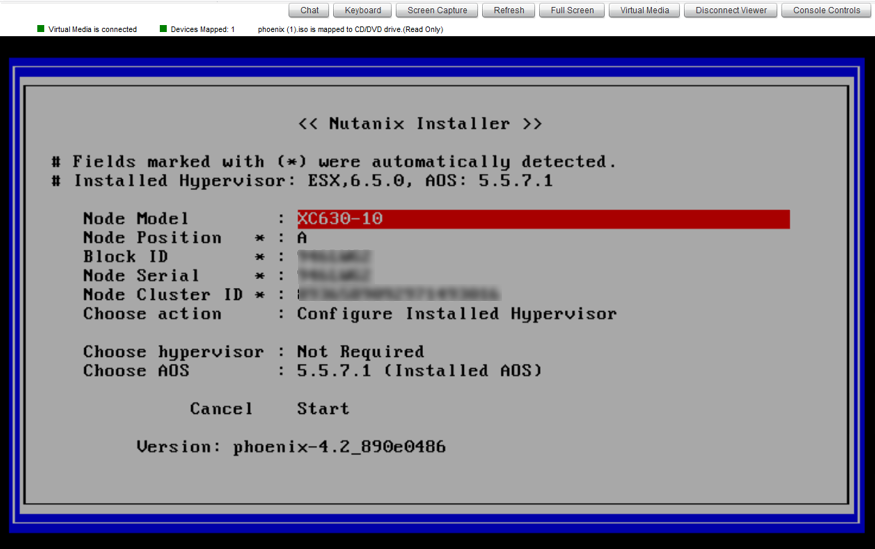

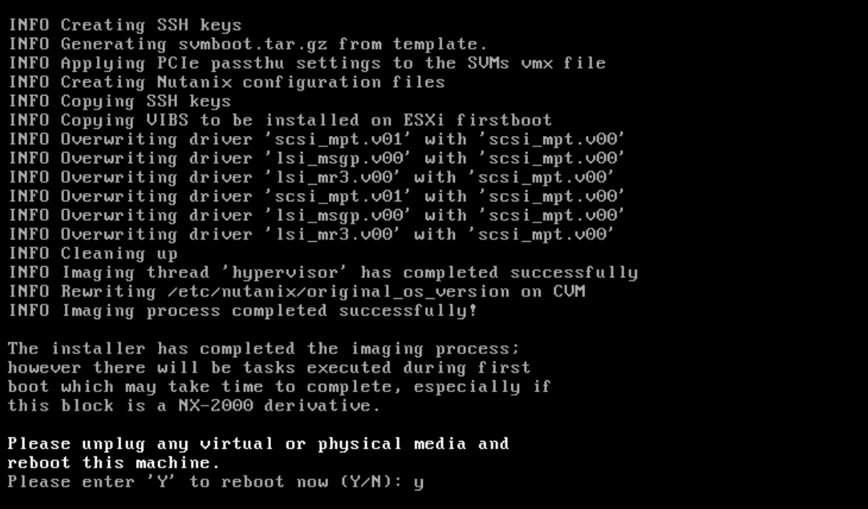

Ensuite, montez l’iso Phoenix et procédez à l’installation : redémarrer le serveur et sélectionner le CD virtuel. Attention, l’option importante n’apparaît que quelques secondes sur le Nutanix Installer. Il faut sélectionner Installer ce qui aura pour action de redonner vie à votre CVM et à une partie de la configuration de votre ESXi.

Vérifiez les informations, mais normalement il n’y a rien à modifier. Enfin, on sélectionne “Start“.

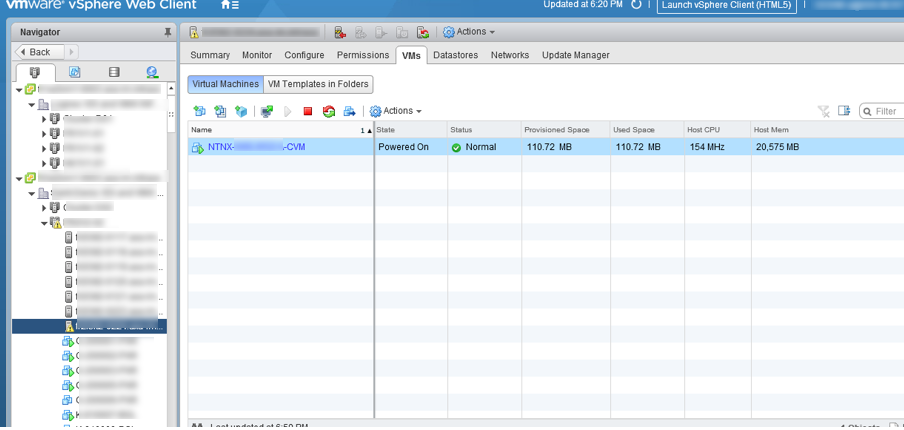

Après de très nombreux reboot (3 ou 4), la CVM est de nouveau disponible !

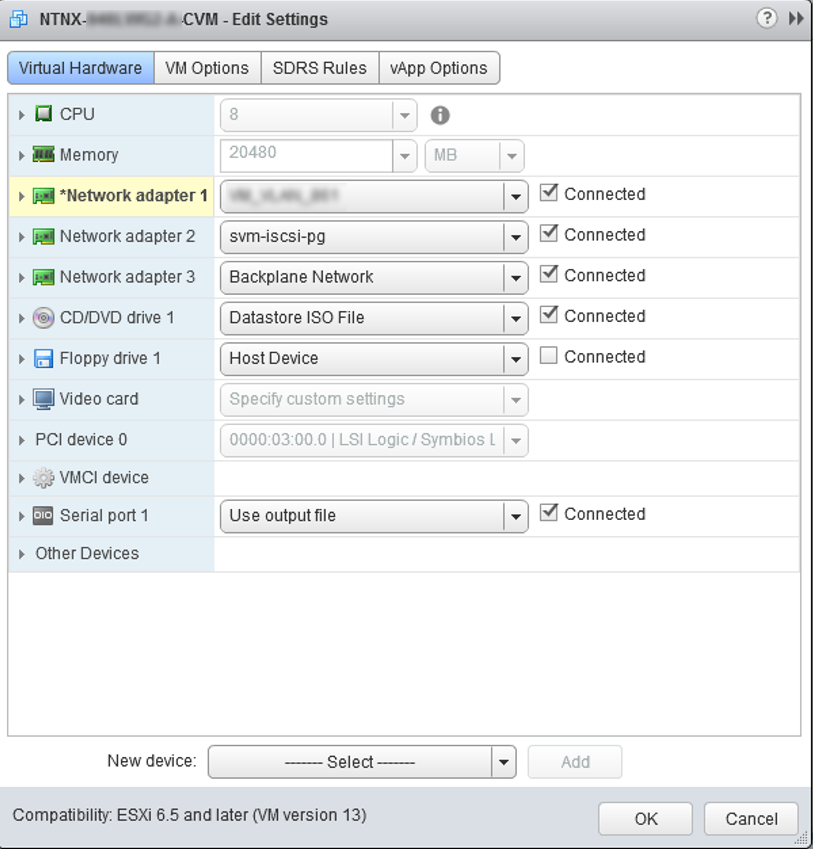

Je reconfigure le bon portgroup afin qu’elle puisse discuter avec ses copines.

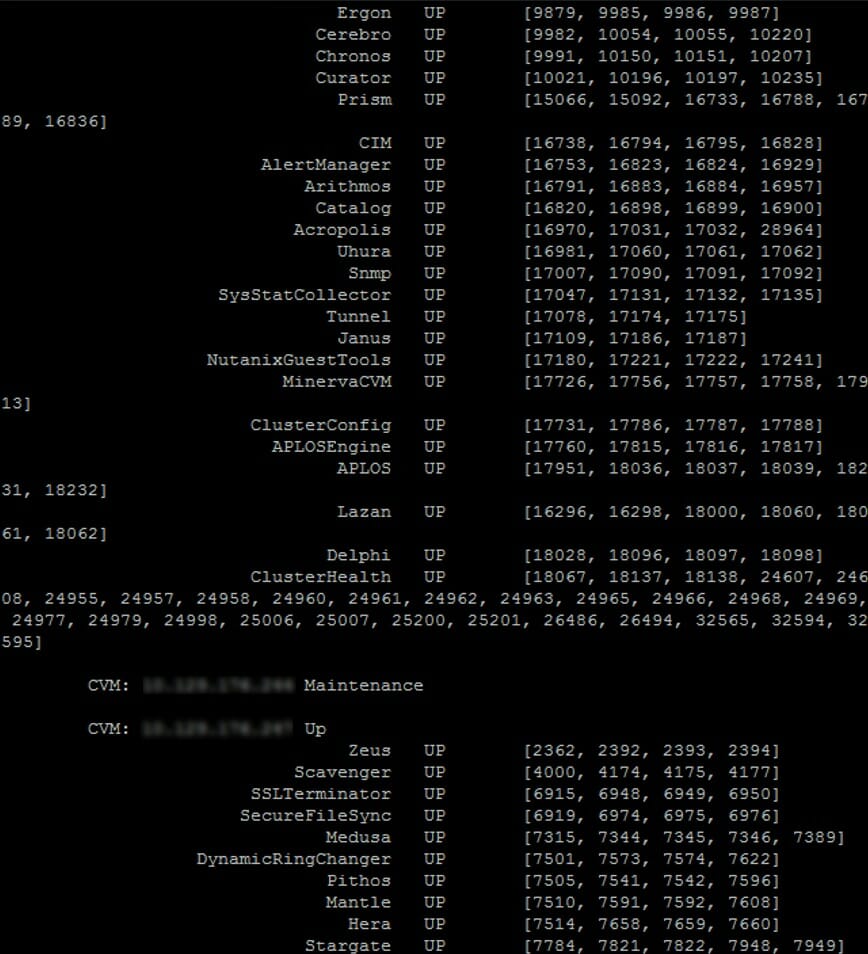

Je ne sais pas si c’est systématique, mais la CVM était restée en maintenance. Mais cela ne me pose plus de problème depuis que j’ai trouvé ce superbe article d’insomnia cloud how-to-fix-nutanix-cvm-being-stuck-in :

ncli host list

ncli host edit id=1337adezd-efrfer-1337-4324de-45dfe enable-maintenance-mode="false"

cluster status

En fonction de votre niveau de personnalisation, il restera peut-être de la configuration sur l’ESXi. Pour ma part, j’ai eu le NTP, quelques portgroups et le vMotion à reconfigurer.

Partager la publication "Repair Host Boost Disk à la main."